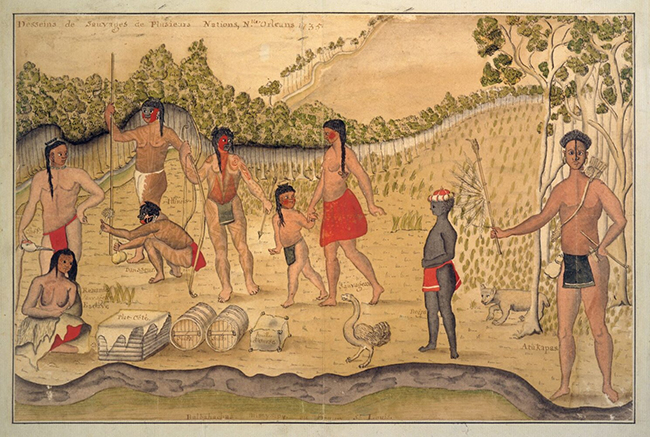

Ein Teilprojekt im Schwerpunktprogramm »Visuelle Kommunikation« versucht, Körpersprache analysierbar zu machen

Gestik hilft den Menschen, einander besser zu verstehen. Auch für die Verständigung zwischen Mensch und Maschine wird sie immer wichtiger.

Alle Fotos: Uwe Dettmar; alle anderen Bilder: Technology Lab

Visuelle Kommunikationsmittel wie Gestik und Mimik sind uralte Formen menschlicher Verständigung. Wer spricht, reiht nicht nur Wörter oder Sätze aneinander, sondern nutzt dafür auch Hände, Arme, Kopf und Gesicht. Seit 2021 erforscht das DFG-Schwerpunktprogramm ViCom an der Goethe-Universität diese nonverbalen Kanäle. Ein Teilprojekt untersucht die Bedeutung von Körpersprache mithilfe von Aufzeichnungsmethoden der Virtuellen Realität (VR).

Der Sprung vom Büro im Fachbereich Informatik in die virtuelle Welt dauert nur wenige Sekunden: VR-Brille auf und schon steht die Probandin (in diesem Fall die Autorin) als Avatar auf der Straße, die durch eine kleine Stadt führt – vorbei an einer Kapelle, durch den Park, hin zur Kirche und dann bis zum Rathaus. Danach soll sie einem anderen Probanden diesen Weg beschreiben, damit er ihn problemlos findet.

Für den Frankfurter Computerlinguisten und Informatiker Prof. Alexander Mehler, den Linguisten Dr. Andy Lücking und den Informatiker Dr. Alexander Henlein können die Dialoge im VR-Labor wertvolle Erkenntnisse liefern: Welche Rolle spielen Gestik und Mimik bei der Wegbeschreibung? Wie wird gesprochene Sprache mit Zeigebewegungen, Gesichtsausdrücken oder anderen nonverbalen Hinweisen kombiniert? Welche Route nimmt der zweite Proband, und was hilft ihm, ans Ziel zu kommen? Diese Fragen wollen die Forscher im Projekt GeMDiS (Virtual Reality Sustained Multimodul Distributional Semantics for Gestures in Dialogue) beantworten.

Zeigen – schon in früher Kindheit eine eindeutige Geste, die der Computer mithilfe von VR-Technologie erst lernen muss.

Gesten: lange Zeit kein Thema in der Linguistik

Galten Gesten in der Sprachforschung lange Zeit als reines Beiwerk verbaler Äußerungen, weiß man heute, dass sie sehr viel mehr sind als das. Es ist ein Unterschied, ob ein Gast im Restaurant ruft, ›das Essen ist versalzen‹, oder ob er dazu mit der Faust auf den Tisch schlägt. »Wir nutzen Gestik und Mimik, weil wir damit mehr Informationen vermitteln können und Kommunikation effizienter wird«, sagt Alexander Mehler und nennt ein weiteres Beispiel: »Wenn ich mit meinem Gesprächspartner über eine bestimmte Pflanze reden will, dann blicke oder zeige ich automatisch in die entsprechende Richtung. So erleichtere ich die Identifikation des Objekts, ohne viele Worte zu verlieren.«

Genau das machen auch die meisten Probanden und Probandinnen bei ihren Wegbeschreibungen in den VR-Versuchen. Das GeMDiS-Team hat in zahlreichen Experimenten beobachtet, dass etwa beim Wort ›Kirche‹ die Hände häufig einen spitzen Winkel formen, um so das Dach näher zu beschreiben. Ein Teich in der virtuellen Landschaft kann gestisch mit einem kreisenden Finger gekoppelt werden. Die These des Projekts: Je häufiger Proband A gesprochene Sprache mit Gestik und Mimik koppelt, desto besser findet Proband B seinen Weg.

Eingeschränkte Gestik – weniger Verständigung

Mittels Virtual-Reality-Technologie kann das GeMDiS-Team auch untersuchen, was geschieht, wenn Körpersprache nur eingeschränkt möglich ist. So kann beispielsweise durch Manipulation der Audio- und Videoausgänge der VR-Brille die Hör- beziehungsweise Sehfähigkeit von Probanden und Probandinnen beeinflusst werden. Innerhalb der VR-Umgebung kann zudem darauf Einfluss genommen werden, inwieweit sie Objekte virtuell greifen und verwenden können: In einem der Experimente war es zum Beispiel nicht mehr möglich, eine virtuelle Tasse vom Tisch zu nehmen. Die Forscher fanden heraus, dass solche Einschränkungen der Handlungsfähigkeit starke Effekte auf die Kommunikation haben, die sich bei technischen Einschränkungen der Hör- und Sehqualität hingegen gerade nicht zeigen: Probandinnen und Probanden, deren Interaktionsmöglichkeiten beschnitten sind, bewegen sich deutlich weniger in der virtuellen Welt, sie reden mehr über ihre Erfahrungen dort und bewerten ihr Erlebnis mit dem Experiment insgesamt negativer.

Jeweils etwa 25 Minuten dauert ein Versuchsdurchgang in Experimenten dieser Art. Anschließend schaut sich das GeMDiS-Team die Bildfolgen genau an und analysiert sie. Der Computer liefert Daten von Hand- und Gesichtsbewegungen aus dem dreidimensionalen Raum. Damit werden im Verlauf des Projekts Modelle für Künstliche Intelligenz (KI) trainiert. Die KI erkennt, wenn sich Beispiele häufen – wenn also bei der Wegbeschreibung ein Wort wie ›Baum‹ oder ›Kreuzung‹ häufig mit einer bestimmten Geste kombiniert wird.

AUF DEN PUNKT GEBRACHT

- In Experimenten mit Virtual Reality (VR) wurde festgestellt, dass die Kombination von verbaler Sprache und Körpersprache (zum Beispiel Gesten) die Verständlichkeit und Orientierung, zum Beispiel bei Wegbeschreibungen, erheblich verbessert.

- In Folgeexperimenten wurde unter anderem die Möglichkeit zur Wahrnehmung von Gestik oder Mimik in der VR technisch eingeschränkt, mit dem Ergebnis, dass die Effektivität der Kommunikation sinkt und dass das Kommunikationserlebnis insgesamt negativer wahrgenommen wird. • Das Projekt GeMDiS nutzt KI, um Muster in der Kombination von verbaler und nonverbaler Sprache zu erkennen. Die unterschiedlichen Kommunikationssignale werden dabei in einem gemeinsamen, multimodalen semantischen Raum abgebildet.

- Ziel ist es, eine multimodale Korpuslinguistik zu etablieren, um gesprochene und nonverbale Sprache gemeinsam zu analysieren und mit dem multimodalen semantischen Raum eine Grundlage für multimodale KI zu schaffen, die zum Beispiel zu einer verbesserten Mensch-Maschine-Interaktion oder einem multimodalen Sprache-Gesten-Lexikon führen kann.

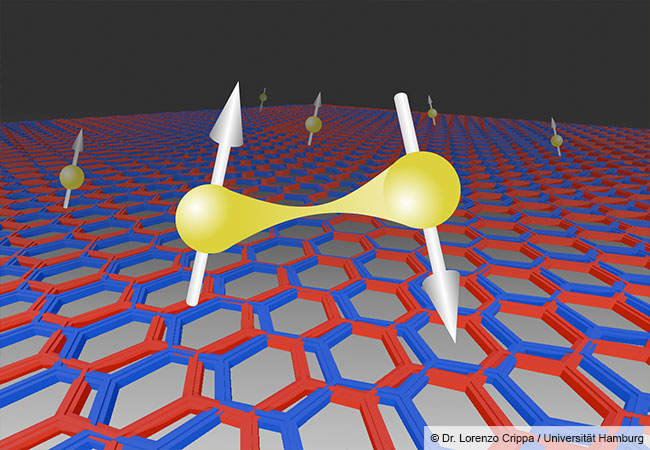

Trainierte KI soll Muster erkennen

Dazu generiert die KI einen sogenannten multimodalen Ähnlichkeitsraum, eine Art mathematische beziehungsweise geometrische Darstellung von gesammelten Daten. Damit können unterschiedliche sprachliche Zeichen wie Wörter, Sätze oder Grammatik sowie nonverbale Zeichen wie Gestik, Mimik oder Körperhaltung vergleichbar gemacht werden. »Der Vorteil ist, dass dieser Ähnlichkeitsraum auch Stellen für Nichtgesagtes und Nichtgestikuliertes bereit-hält. Diese Stellen müssen nicht von der KI beobachtet werden, erleichtern aber das Erkennen von immer neuen Gesten oder Sprachdaten«, erläutern die Wissenschaftler. So könne, was zuvor beim Training der Algorithmen nicht gesehen worden sei, dennoch später ›erkannt‹ werden.

Die Frankfurter Informatiker und Linguisten nutzen somit eine Methode, die bei der gesprochenen und geschriebenen Sprache schon länger üblich ist. Bei der sogenannten korpusbasierten Linguistik geht es um die Analyse von Sprachdaten aus großen Textsammlungen, sogenannten Korpora. Ziel ist es, Muster zu erkennen – zum Beispiel auf der Ebene grammatischer Strukturen oder von Worthäufigkeiten. Außerdem wird analysiert, wie sich sprachliche und nichtsprachliche Einheiten aufeinander beziehen, um daraus Vorhersagen abzuleiten. Diese Methode erlaubt es, Veränderungen von Sprache sehr feingliedrig zu dokumentieren oder zu visualisieren, wie Ausdrücke in unterschiedlichen Kontexten verwendet werden. Das ist keine reine Spielwiese für Theoretiker, sondern kann in der Praxis helfen, die Verständigung zwischen Mensch und Maschine zu verbessern – etwa bei Spracherkennungssystemen oder bei Systemen, die auf gestischer Steuerung basieren.

Gesten haben eine große Bandbreite

Mit der Analyse von nonverbaler Sprache wie Gestik oder Mimik hat sich die Korpuslinguistik bisher deutlich weniger beschäftigt; entsprechende Korpora fehlen. Deshalb will das GeMDiS-Team dazu beitragen, die Datenlücke mithilfe multimodaler Korpuslinguistik zu schließen, indem also gesprochene und non-verbale Sprache in Kombination analysiert wird. Methodisch ist das eine Herausforderung. Während es bei gesprochener und geschriebener Sprache darum geht, Wörter jeweils mit ihrer zugeordneten Bedeutung zu erfassen, ist visuelle Kommunikation deutlich komplexer. »Die redebegleitende Gestik ist nicht festgelegt, nicht kodifiziert – anders als etwa die Gebärdensprache. Zeige-Gesten zum Beispiel haben je nach Kontext ganz unterschiedliche Bedeutungen«, erläutert Prof. Mehler. »Auch die Form-Varianz ist anders als bei der gesprochenen Sprache sehr groß. Gesten sind nicht immer gleich. Wenn zum Beispiel meine Hand verletzt ist, dann mache ich andere Zeigebewegung als ohne die Einschränkung.« Hinzu kommt, dass die Bedeutung von Gesten variieren kann – je nachdem, wo und von wem sie benutzt werden. Wer mit dem Kopf nickt, stimmt zu? Nicht immer. In Griechenland etwa bedeutet die Geste nicht ›ja‹, sondern ›nein‹.

Zurück zur Gestenforschung im VR-Labor an der Frankfurter Robert-Mayer-Straße. Das GeMDiS-Team muss noch viele Dialoge in der virtuellen Welt beobachten, multimodale Informationen sammeln und auswerten, damit später auch andere Wissenschaftlerinnen und Wissenschaftler mit dem Datenschatz arbeiten können. Die Ergebnisse des ViCom-Teilprojekts dürften langfristig dazu beitragen, die Interaktion von Mensch und Maschine zu erleichtern. Aus dem Forschungsprojekt könnte aber auch ein multimodales Gesten-Lexikon entstehen – analog zu Wörterbüchern für Fremdsprachen. Die Idee ist, zum Beispiel Begrüßungsformeln mit Bildern wie Handschlag, Verbeugung oder ähnlichen Symbolen darzustellen. Interessante Erkenntnisse könnte die VR-basierte Aufzeichnungstechnologie an der Goethe-Universität außerdem für die Gebärdensprache bringen. In Kooperation mit der Universität Köln will das GeMDiS-Team herausfinden, welche Rolle Mundbewegungen bei Wegbeschreibungen spielen. Denn für Gehörlose sind solche Gesten sehr wichtig, um Aussagen zu verstehen. Mundbilder und Mundformen sind fester Bestandteil der Gebärdensprache.

Visuelle Kommunikation

»Man kann nicht nicht kommunizieren«, hat der Philosoph und Kommunikationswissenschaftler Paul Watzlawick gesagt. Selbst wenn Worte fehlen, übermitteln Menschen mit ihrem Körper Botschaften. Das DFG-Schwerpunktprogramm »Visuelle Kommunikation« (ViCom) nimmt diese außersprachliche Verständigung genauer in den Blick. Im Verbundprojekt zwischen der Frankfurter Goethe-Universität und der Universität Göttingen untersuchen Wissenschaftlerinnen und Wissenschaftler unterschiedlicher Fachrichtungen zum Beispiel, was Gesten und Gebärden gemeinsam haben, was Gesten in der Didaktik oder in therapeutischen Kontexten bewirken, wie Tiere kommunizieren und wie die Interaktion zwischen Mensch und Computer funktioniert. ViCom hat das Ziel, ein neues Kommunikationsmodell zu entwickeln, das die Vielschichtigkeit von Verständigung erfasst.

Zu den Personen

Prof. Dr. Alexander Mehler hat seit 2013 den Lehrstuhl für Computational Humanities/Text Technology im Fachbereich für Informatik und Mathematik der Goethe-Universität inne. Er wurde an der Universität Trier im Fach Computerlinguistik promoviert. Seine Forschungsinteressen umfassen die quantitative Analyse, simulative Synthese und formale Modellierung von Texteinheiten in der gesprochenen und schriftlichen Kommunikation. Zu diesem Zweck untersucht er linguistische Netzwerke auf der Grundlage zeitgenössischer und historischer Sprachen (unter Verwendung von Modellen der Sprachevolution). Ein aktuelles Forschungsinteresse betrifft 4D-Texttechnologien, die auf Virtual Reality (VR), Augmented Reality (AR) und Augmented Virtuality (AV) basieren.

mehler@em.uni-frankfurt.d

Dr. habil Andy Lücking ist Privatdozent und Principal Investigator im Text Technology Lab an der Goethe-Universität. Er hat Linguistik, Philosophie und Germanistik an der Universität Bielefeld studiert und wurde dort mit einer Arbeit zur multimodalen Grammatikerweiterung promoviert. Als Postdoc arbeitete er in der Computerlinguistik/Texttechnologie, mit einer Arbeit über multimodale Dialogtheorie, insbesondere eine »gestenfreundliche« semantische Theorie von Pluralausdrücken und Quantifikation, hat er sich an der Université Paris Cité habilitiert. Besonders interessiert er sich für die linguistische Theorie der menschlichen Kommunikation, das heißt die Interaktion von Angesicht zu Angesicht innerhalb und jenseits einzelner Sätze. Dabei gilt sein besonderes Augenmerk den verschiedenen Arten von Gesten und kognitiver Modellierung.

luecking@em.uni-frankfurt.de

Dr. Alexander Henlein ist Postdoc am Text Technology Lab der Goethe-Universität. Im Studium der Informatik an der Goethe-Universität lag sein Hauptinteresse auf dem automatisierten Sprachverständnis von Computern. In seiner Dissertation hat er zu Text-to-3D Scene Generation geforscht und sich der Frage gewidmet, wie aus Sprache dreidimensionale Welten entstehen können. Aktuell beschäftigt er sich mit multimodaler Sprache und Kommunikation, insbesondere im Zusammenhang mit modernen Sprachmodellen. Er arbeitet an der Entwicklung eines VR-basierten Systems zur Sammlung und Analyse multimodaler Daten.

henlein@em.uni-frankfurt.de

Die Autorin

Katja Irle,

Jahrgang 1971, ist Bildungs- und Wissenschaftsjournalistin, Autorin und Moderatorin.

irle@schreibenundsprechen.eu

Zur gesamten Ausgabe von Forschung Frankfurt 1/2025: Sprache, wir verstehen uns!